本篇目录:

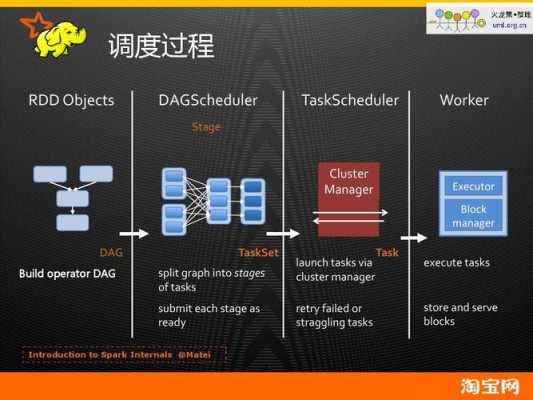

spark工作原理和介绍

Spark 6 之后默认为统一管理(UnifiedMemoryManager)方式,6 之前采用的静态管理(StaticMemoryManager)方式仍被保留,可通过配置 spark.memory.useLegacyMode=true 参数启用静态内存管理方式。

Spark是基于内存的迭代计算框架,适用于需要多次操作特定数据集的应用场合。

spark基本原理 构建在Spark上处理Stream数据的框架,基本的原理是将Stream数据分成小的时间片段(几秒),以类似batch批量处理的方式来处理这小部分数据。

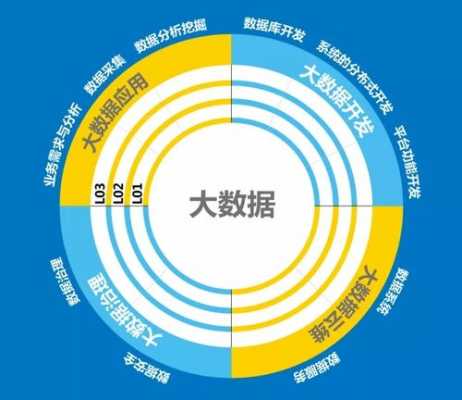

什么是大数据技术专业

1、大数据技术专业属于交叉学科:以统计学、数学、计算机为三大支撑性学科;生物、医学、环境科学、经济学、社会学、管理学为应用拓展性学科。

2、大数据技术专业是通常叫做数据科学与大数据技术,而在专科层次通常叫做大数据技术与应用,大数据技术专业属于交叉学科。

3、大数据技术专业是结合国家大数据、人工智能产业发展战略而设置的新兴专业,该专业面向大数据应用领域,主要学习大数据运维、采集、存储、分析、可视化知识和技术技能。

大数据中的Spark指的是什么?

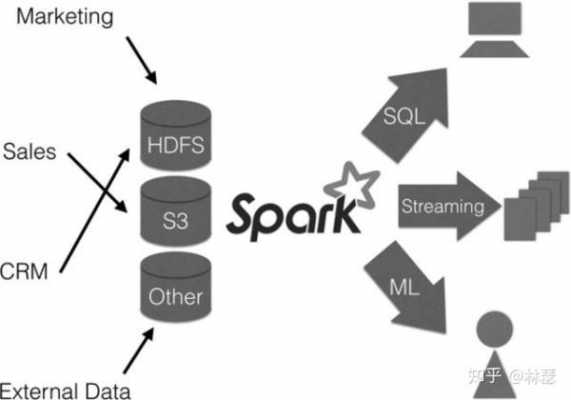

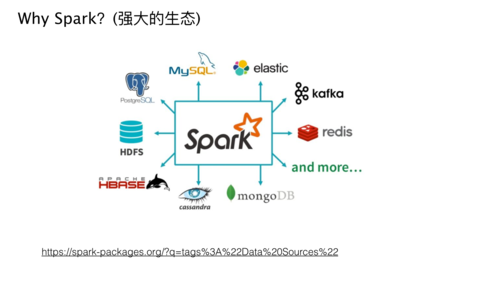

spark是一个通用计算框架。Spark是一个通用计算框架,用于快速处理大规模数据。Spark是一种与Hadoop相似的开源集群计算环境,但Spark在内存中执行任务,比Hadoop更快。

Spark是基于内存,是云计算领域的继Hadoop之后的下一代的最热门的通用的并行计算框架开源项目,尤其出色的支持Interactive Query、流计算、图计算等。Spark在机器学习方面有着无与伦比的优势,特别适合需要多次迭代计算的算法。

Spark是基于内存的迭代计算框架,适用于需要多次操作特定数据集的应用场合。

Spark,是一种One Stackto rule them all的大数据计算框架,期望使用一个技术堆栈就完美地解决大数据领域的各种计算任务。Apache官方,对Spark的定义就是:通用的大数据快速处理引擎。

**Spark编程框架:** 在计算机科学中,Spark 是一个开源的、高性能的分布式计算框架,用于大规模数据处理。它支持多种编程语言,并广泛应用于大数据处理和机器学习等领域。

Apache Spark 是专为大规模数据处理而设计的快速通用的计算引擎。

到此,以上就是小编对于spark数据挖掘代码的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏